OllamaデスクトップでローカルLLMしてみる。ローカルLLMが簡単に使えるようになった

ローカルLLM環境を簡単に構築できる「Ollama」にデスクトップアプリができたというので、試してみることにした。

公式サイトの記事によると、WindowsとMac用に用意されているらしい。

WindowsにOllamaアプリをインストールし、実行する

早速、公式サイトからWindows用のインストーラーをダウンロードし、デスクトップにインストールしてみる。

インストールには特筆するようなこともなく、すぐにインストールできてしまった。

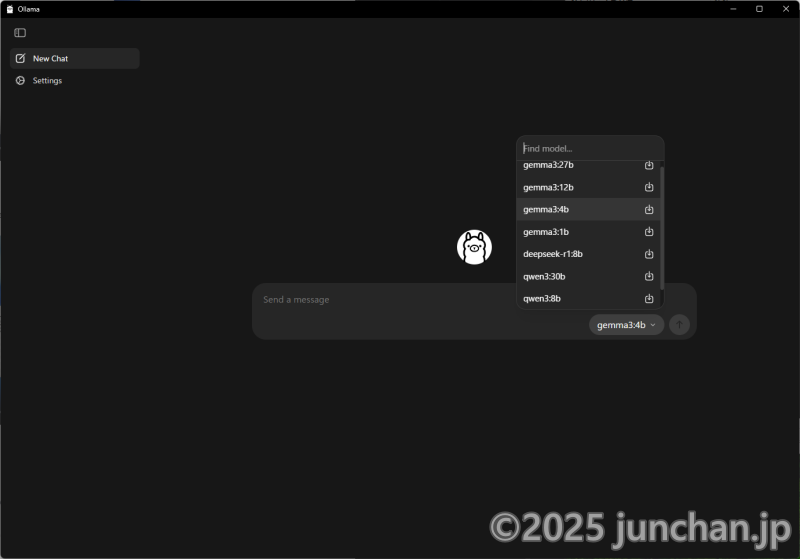

アプリを起動すると、シンプルな画面が出てきた。Ollamaのシンボルであるアルパカがかわいい。

アプリはダークモードに対応していたようで、黒背景に白文字の、私にとっては馴染んだ画面だ。システム設定あたりから読み取ってくれたのだろう。

チャット枠の右下にモデルを選択するところがあって、ここでモデルの切り替えができそうだ。

モデルの選択肢を見ていると、Ollama自体はもっと多くのモデルに対応しているんだけど、デスクトップで使えるのはその一部なのかな?といった様子。

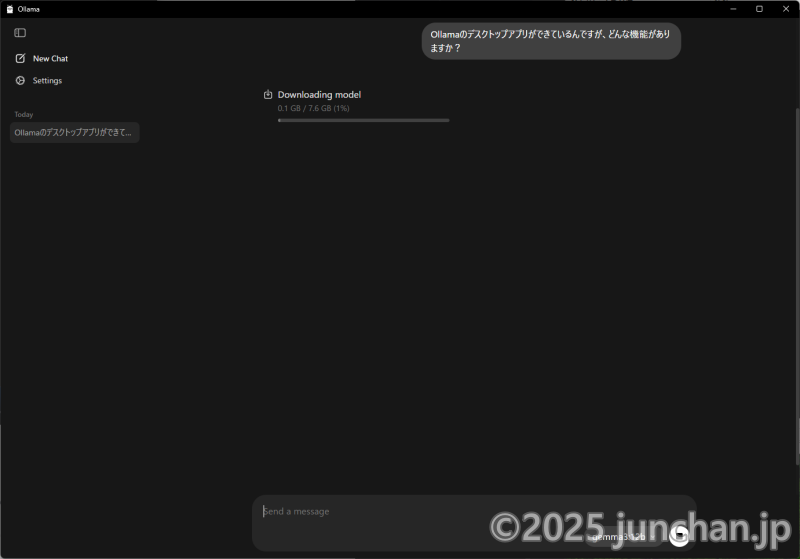

適当にモデルを選んでチャットを開始すると、まずは指定のモデルのダウンロードがはじまった。

我が家のデスクトップだと、「Gemma3:12b」くらいは実用的な速度で動くことがLM Studioで確認済みだから、まずはGemma3:12bを使ってみることにした。

モデルのダウンロードが終わったら、すぐに回答が作られた。

回答の内容自体はGemma3:12bの能力を発揮してくれていることだろう。

モデルのダウンロードには時間がかかるが、一旦ダウンロードしてしまえば、その後の会話はスムーズである。

ローカルLLM環境構築がスムーズに実行できた!

Ollamaデスクトップアプリをインストールして、アプリを起動し、チャットをはじめたらLLMのモデルがダウンロードされ、回答が生成された。

言うなれば、ローカルLLM環境がこの一連の流れだけで構築できたってことだ。これはとてもスムーズに構築できたと言っていいだろう。

LM Studioでも同じくらいの工程で簡単にローカルLLM環境を構築できたが、Ollamaは更にこれがわかりやすくなっていると思う。

もともとOllamaはターミナルで会話するようになっていて、デスクトップ環境はなく、必要に応じてサードパーティーのデスクトップアプリに相当するものを用意してやる必要があった。Open WebUIが有名どころか。

私も前にOllama + Open WebUIの実行環境をDockerで作ったことがあるが、それなりに手間だったのを覚えている。まずOllamaがCUIで対話するものであって、それをGeminiなどのようにデスクトップで使うのであれば・・・というあたりから理解が必要だったからな。

Ollama自体がデスクトップアプリを作ったことで、この手間が全く必要なくなった。おかげで、細かいことがよくわからなくても、ワンストップでローカルLLM実行環境が作れるようになったと言えるだろう。

モデルの切り替えも簡単にできるし、これはものすごく便利になったと思う。

LM Studioと比べてシンプル

LM StudioでやっていたことがOllamaだけでもできるようになった。すると、これらの違いが気になるところだろう。

私としては、LM Studioは先行しているだけあって、カスタマイズが豊富にできるようになっている印象だ。未だによくわからない項目があるし。まあ、わからなくても生成AIを動かす分には問題ないのだけれど。

これに対し、Ollamaデスクトップは遥かにシンプルに作られている感じがする。必要最低限の機能を付けてまずはリリースしました、という印象。悪くない。

ひとまずローカルLLM環境を作りたいなら、どちらのアプリを選んでもいいけど、あえて言うならOllamaの方が簡単につくれて、設定項目が少ない分、悩みは少なくていいかな、と思う。

ただ生成AIを使って文章を生成するだけなら、Ollamaデスクトップで十分事足りるだろう。

実行速度に関しても、同じモデルを使ってみた感じだと大差ないと思う。

一方で、LLMの動作をよく理解したいとか、LLMの性能を最大限に引き出したいとかいう場合はLM Studioの方がよさそうかな。

あえていうと、両アプリでモデルが共用できたらよかったかもなぁ、と思わないでもない。LLMはそれなりに容量が大きいので、何回もダウンロードしたくない。ただ、それぞれ全く違うフォーマットで管理しているから、それぞれのアプリでモデルをダウンロードしてやる必要があるようだ。まあ、これは言っても詮無きことか。LM StudioとOllamaをどちらも同じマシンで使うというケースは少なそうだし。

Ollamaに聞いてみた!

実際にOllamaを使って文章を作ってみたらこんな感じだった。LLMはGemma3:12bを使用している。

回答は長いので折りたたんでおく。

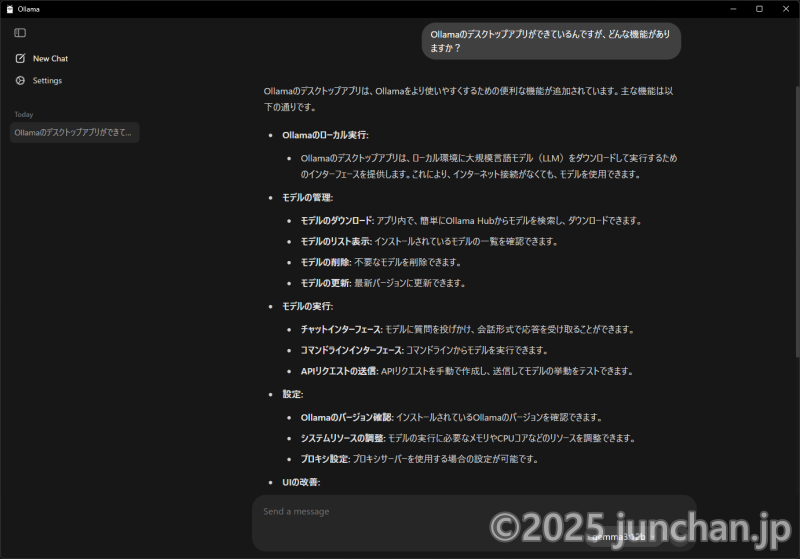

Ollamaのデスクトップアプリができているんですが、どんな機能がありますか?

Ollamaの回答は・・・

Ollamaのデスクトップアプリは、コマンドライン操作が中心だったOllamaをより手軽に利用できるように設計されています。主な機能は以下の通りです。

1. モデル管理機能

- モデルのダウンロード: Ollama Hubから簡単にモデルを検索・ダウンロードできます。人気モデルから、専門分野のモデルまで、幅広い選択肢があります。

- モデルの表示: ダウンロード済みのモデルの一覧が表示されます。

- モデルの削除: 不要なモデルを削除できます。

- モデルの更新: 最新バージョンのモデルに更新できます。

2. チャット機能

- チャット開始: ダウンロードしたモデルを選択し、すぐにチャットを開始できます。

- プロンプト入力: テキストボックスにプロンプトを入力し、LLMへの質問や指示を送信できます。

- 応答表示: LLMからの応答がリアルタイムで表示されます。

- 会話履歴の保存: 会話履歴を保存し、後で参照できます。

3. 設定機能

- テーマ変更: アプリのテーマを、ライトモードとダークモードの間で切り替えられます。

- 言語設定: アプリの言語を設定できます。

- プロキシ設定: プロキシサーバーを使用している場合は、プロキシ設定を構成できます。

4. その他機能

- Ollama Hubへのアクセス: アプリ内からOllama Hubにアクセスし、新しいモデルを探したり、コミュニティに参加したりできます。

- ヘルプへのアクセス: アプリの使い方やトラブルシューティングに関するヘルプ情報を参照できます。

- フィードバックの送信: アプリの改善点や要望を開発者に送信できます。

デスクトップアプリのメリット

- GUIによる操作性: コマンドライン操作に慣れていない人でも簡単に操作できます。

- モデルの視覚的な管理: ダウンロード済みのモデルが一覧表示され、視覚的に管理できます。

- チャット履歴の保存: 会話履歴を保存し、後で参照できます。

- Ollama Hubへのアクセス: アプリ内からOllama Hubに簡単にアクセスできます。

補足

- デスクトップアプリは、コマンドラインツールと連携して動作します。

- 一部の高度な設定は、コマンドラインツールで構成する必要があります。

- デスクトップアプリは、継続的にアップデートされており、新しい機能が追加されることがあります。

Ollamaのデスクトップアプリは、ローカルLLMの利用をさらに手軽にするための強力なツールです。ぜひ試してみてください。

おわりに

Ollamaがデスクトップアプリを作ったというので、インストールして使ってみた。

アプリを起動してから生成AIによって文章を作るところまで、非常にスムーズにはじめられたと思う。

似たようなものにLM Studioがあるが、それに比べるとよりシンプルにローカルLLM環境を作ることができたという印象だ。

UIもこなれていて、あんまり悩むことなく、直感的に使えた。

ローカルLLMがますます身近になったものだと思う。